Une question récurrente lorsqu’on aborde les IA génératives est celle de la « réglementation ». C’est un des premiers sujets de préoccupation pour les entreprises et les organismes de formation qui intègrent l’IA dans leurs pratiques.

Ainsi, il n’est plus seulement question d’usage de l’IA mais aussi surtout comment l’utiliser de manière responsable, en veillant à réguler et encadrer ces systèmes pour éviter de potentielles dérives.

Retour sur l’IA Act, le règlement IA européen IA et sa mise en application en formation.

L’IA ACT, kesako ?

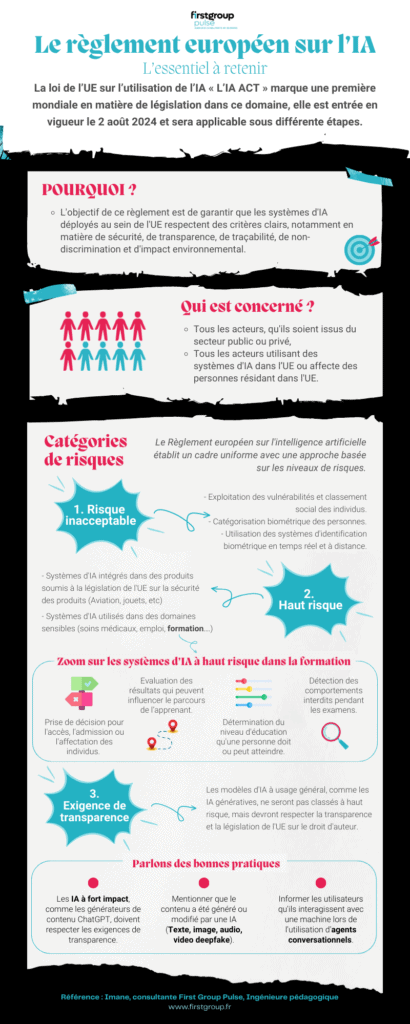

L’IA ACT est le règlement IA européen, c’est la première législation mondiale couvrant l’IA de manière exhaustive. Il vise à garantir que les systèmes d’IA utilisés dans l’UE respectent des normes strictes en matière de sécurité, transparence, non-discrimination et durabilité. Ce cadre s’applique aux acteurs publics et privés, qu’ils opèrent au sein ou en dehors de l’UE, dès lors que leurs systèmes impactent des personnes dans l’Union.

Ce règlement s’articule autour d’une définition prospective de l’IA et d’une approche fondée sur des catégories de risques.

Les catégories de risque du règlement IA à retenir

Le règlement IA introduit un cadre uniforme applicable dans tous les États membres de l’UE, qui s’articule autour d’une définition prospective de l’IA et d’une approche fondée sur les risques :

- La catégorie « Risque inacceptable » : regroupe un ensemble très limité d’utilisations particulièrement néfastes de l’IA qui sont contraires aux valeurs de l’UE parce qu’elles portent atteintes à des droits fondamentaux, et seront donc interdites.

Par exemple : l’exploitation des vulnérabilités, le classement social des individus et la catégorisation biométrique des personnes. - La catégorie « Haut risque » : regroupe les systèmes d’IA qui ont un impact négatif sur la sécurité des personnes ou sur leurs droits fondamentaux.

Par exemple : Les systèmes d’IA qui sont utilisés dans la sécurité des produits (dispositifs médicaux, ascenseurs, etc) ou relevant de quelques domaines spécifiques (soins médicaux, emploi, formation, etc). - La catégorie « Exigence de transparence » : Les modèles d’IA à usage général à fort impact et qui sont susceptibles de présenter un risque systémique, ne seront pas classés à haut risque.

Par exemple : Le générateur de contenu « ChatGPT » du modèle le plus avancé en IA « OpenAI » est classé dans cette troisième catégorie.

Quels classements pour les systèmes d’IA utilisés en formation

Ainsi, les systèmes d’IA utilisés dans la formation professionnelle sont considérés comme à haut risque, surtout lorsqu’ils influencent des décisions importantes concernant les apprenants. Cela inclut :

- les systèmes déterminant l’accès ou l’admission à des formations ;

- les systèmes évaluant les résultats d’apprentissage, notamment lorsque ces résultats sont utilisés pour orienter le parcours d’apprentissage ;

- les systèmes d’IA évaluant le niveau d’éducation qu’une personne peut atteindre ;

- les systèmes d’IA surveillant et détectant les comportements interdits lors des tests.

Une mauvaise gestion de ces systèmes peut avoir des répercussions significatives sur l’avenir des apprenants, justifiant ainsi leur classification à haut risque.

Comment assurer la transparence dans l’utilisation des systèmes d’IA ?

À mesure que ces technologies se généraliseront dans la formation professionnelle, il est essentiel de respecter certaines exigences de transparence, entre autres :

- Bien communiquer sur la source du contenu,

- Respecter les droits d’auteurs,

- Éviter de générer du contenu illégal, et

- Garantir une clarté sur l’utilisation des données.

Les bonnes pratiques à mettre en place en formation pour s’aligner au règlement IA

Afin de garantir une utilisation responsable des systèmes d’IA dans le domaine de la formation, voici quelques bonnes pratiques :

- Pour les contenus générés ou modifiés par l’IA, tels que des images, fichiers audio ou vidéo (y compris les « deepfakes ») : il est important qu’ils soient clairement étiquetés comme étant produits par une intelligence artificielle générative.

- Pour les systèmes d’IA interactifs, comme les agents conversationnels (chatbots) : ils doivent indiquer explicitement aux utilisateurs qu’ils communiquent avec une machine, et non avec une personne.

Pour aller plus loin

Intégrer l’IA dans les processus de formation nécessite avant tout de se conformer aux nouvelles régulations qui cherchent à encadrer son utilisation. Ces mesures visent à garantir une utilisation éthique, responsable et transparente, notamment dans un secteur aussi sensible que la formation. L’objectif est non seulement de prévenir les abus potentiels, de protéger les utilisateurs, mais également d’instaurer un cadre de confiance. Cela permet à l’innovation technologique de véritablement bénéficier à tous : les apprenants, les formateurs et, au-delà, les institutions éducatives.

Les directions formation jouent un rôle clé dans ce processus, en s’assurant que chaque action formation liée avec l’IA soit responsable, dans le respect du règlement IA. C’est pourquoi, First Group met à disposition de ses clients une délégation de consultants en formation spécialistes de l’IA à l’image de Imane qui ne se contente pas de conseiller mais s’implique directement dans la réalisation de vos projets.

Parlons-en : Agence Ed-Tech – FirstGroup .

*Ce contenu a été légèrement modifié par une IA générative.